Der Schreckmoment: Zwischen zwei parkierten Autos läuft plötzlich ein Kind vor Ihr Auto. Es ist zu spät, um zu bremsen. Wahrscheinlich würde jeder intuitiv zum Schutze des Kindes versuchen, auszuweichen und Schäden am Fahrzeug in Kauf zu nehmen.

Heute trifft der Autofahrer (unbewusst) die Entscheidung

Solche Situationen sind glücklicherweise sehr selten. Noch seltener müssen Fahrer entscheiden, wen sie bei einem Unfall in Lebensgefahr bringen: Stellen Sie sich vor, Sie bemerken beim Fussgängerstreifen eine Gruppe zu spät. Sie können entweder in die Gruppe oder rechts in die Mauer fahren – was Sie tödlich verletzen könnte. Sie treffen diese Entscheidung instinktiv, ein «richtig» oder «falsch» gibt es nicht.

Auch selbstfahrende Autos können diese Situationen nicht gänzlich verhindern, interagieren doch auch sie mit den Menschen auf der Strasse. Unfälle werden leider auch dann noch zur Mobilität gehören, wenn wir uns bequem zurücklehnen und im Auto ein Buch lesen, einen Film schauen oder arbeiten. Allerdings wird in diesem Moment das Auto, nicht Sie, die Entscheidung treffen müssen.

Selbstfahrende Autos erhöhen die Sicherheit

Autonomes Fahren wird die Sicherheit auf den Strassen deutlich erhöhen. Die Autos fahren nie zu schnell, drängeln nicht, halten die nötigen Abstände und fahren nicht in angetrunkenem Zustand. 2016 gab es auf Schweizer Strassen 17‘500 Unfälle mit Personenschaden. 80 bis 94 Prozent dieser Unfälle wären gemäss Schätzungen diverser Experten vermeidbar. Eine Studie des Beratungsunternehmens McKinsey geht deshalb davon aus, dass sich diese Zahl mit selbstfahrenden Autos um 90% reduzieren wird. Wiederum nur ein Bruchteil davon wird Menschen gefährden.

Braucht es eine «Ethik-Software»?

Selbstfahrende Autos werden mit einer komplexen Software ausgerüstet. Diese wird immer versuchen, Menschen nicht zu Schaden kommen zu lassen. Wie das Auto entscheiden soll, wenn es keinen Ausweg mehr gibt, darüber diskutieren Ethiker weltweit. So hat etwa das renommierte Massachusetts Institute of Technology (MIT) diverse Szenarien kreiert, in denen man selbst das moralische Dilemma lösen muss: Die Bremsen bei einem selbstfahrenden Auto versagen. Wer soll gerettet werden? Männer oder Frauen? Junge oder Alte? Ärzte oder Diebe? Die Insassen des Autos oder die Fussgänger? Treffen Sie die Entscheidungen.

Arzt oder Dieb? Alt oder jung? Ich oder du?

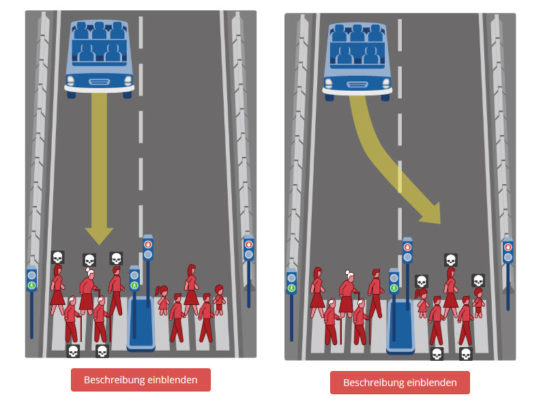

Solche Experimente sind interessante Gedankenspiele – das ethische Dilemma wird die Software kaum lösen, denn Autos werden wohl nie erkennen können, ob jemand ein Dieb oder Arzt ist, ob jemand 20 Jahre oder 80 Jahre alt ist. Sollen immer so viele Leute wie möglich gerettet werden? Soll der Zufall entscheiden? Kann der Fahrer zwischen den Modi «Rette mich» oder «Rette die anderen» entscheiden, so wie es heute einen Sport- und einen Umweltmodus gibt? Am sinnvollsten wäre wohl die Lösung, welche die Aufprallswucht auf das Minimum reduziert. Aber auch diese Option hat ihre Vor- und Nachteile.

Wie entscheiden Sie sich? Fahren Sie gerade aus auf die Personen, die über die Strasse dürfen? Oder fahren Sie auf die Leute zu, bei denen die Ampel auf Rot steht?

Moralisches und rechtliches Dilemma

Für die Hersteller und den Gesetzgeber sind solche Fragen schwierig zu lösen. Die Fragen des MIT zeigen, dass nicht jeder dem selben moralischen Kompass folgt. Was die Mehrheit entscheidet, muss nicht richtig sein, schon gar nicht, wenn die Entscheidung am Computer und nicht in der Realität getroffen wird. Zu guter Letzt verbietet unsere Bundesverfassung, Menschenleben gegeneinander aufzurechnen. «Nur» ein Toter ist also nicht besser als fünf Tote.

Neben diesen moralischen Entscheidungen stellt sich die Frage, wer die Verantwortung übernehmen muss. Der neue Audi A8 bringt schon heute alle technischen Funktionen mit, damit man im Stau auf der Autobahn das Fahren dem A8 überlassen kann. In Kürze wäre auch das Fahren und Überholen bis Tempo 130km/h möglich. Jedoch ist in der Schweiz die Gesetzgebung für das autonome Fahren noch nicht so weit. Der Fahrer ist noch immer vollumfänglich verantwortlich und muss immer mindestens eine Hand am Lenkrad haben. Deutschland hat im Sommer 2017 bereits erste rechtliche Grundlagen für autonomes Fahren erlassen, woran sich die Schweizer Gesetzgebung aktuell orientiert. Wie ist aber die Haftung bei einem Unfall geregelt? Ganz einfach: «Wer fährt, der haftet. Das bedeutet: Wenn das Auto im automatisierten Zustand unterwegs ist und der Fahrer nicht aufgefordert wurde, die Steuerung wieder zu übernehmen, haftet der Hersteller. Sonst haftet weiterhin der Lenker», erklärt Volker Dohr, Anwalt der AMAG Group AG.

Es braucht den gesellschaftlichen Diskurs

Wir werden die «Grundregeln» für autonomes Fahren als Gesellschaft definieren müssen. Dazu müssen wir aber vor allem die Mobilität von morgen im Blick haben: Dank autonomen Fahrzeugen gibt es deutlich weniger Unfälle mit Verletzten oder Todesopfern. Mobilität ist allen zugänglich. Egal wie alt man ist, ob man müde ist oder nicht, man hat immer die Möglichkeit von A nach B zu reisen. Die Frage, was in der seltensten Extremsituation geschieht, sollte die an sich positive Entwicklung nicht stoppen.

Mehr zum autonomen Fahren erfahren

Aktuelles und Hintergründe aus der Welt des Autos. Jetzt abonnieren.