Moment d’effroi: un enfant surgit tout à coup entre deux voitures garées et passe en courant devant votre véhicule. Il est trop tard pour freiner. Il est probable que tout le monde tenterait intuitivement de donner un coup de volant pour protéger l’enfant, quitte à endommager le véhicule.

Aujourd’hui, l’automobiliste prend (inconsciemment) la décision

De telles situations sont heureusement fort rares. Il est encore plus rare que les conducteurs doivent décider qui mettre en danger de mort en cas d’accident. Imaginez que vous remarquez trop tard un groupe sur le passage piéton: vous pouvez soit percuter le groupe, soit vous fracasser contre le mur de droite – et courir le risque d’être mortellement blessé. Vous prenez cette décision instinctivement; il n’y en pas de «bonne» ou de «mauvaise».

Même les voitures autonomes ne peuvent éviter entièrement ces situations puisqu’elles interagissent aussi avec les gens dans la rue. Les accidents feront, malheureusement, encore partie de la mobilité lorsque nous nous installerons confortablement pour lire un livre, regarder un film ou travailler dans notre voiture. Cependant, ce sera à ce moment la voiture, et non vous, qui devra prendre la décision.

Une sécurité accrue avec la voiture autonome

La conduite autonome va nettement accroître la sécurité routière. Les voitures ne rouleront jamais trop vite, ne «colleront» pas aux autres véhicules, respecteront les distances nécessaires et ne conduiront pas en état d’ébriété. En 2016, il y a eu sur les routes suisses 17 500 accidents avec dommages aux personnes. 80 à 94% de ces accidents pourraient, selon les estimations de divers experts, être évités. Une étude du cabinet de conseil McKinsey table en conséquence sur une réduction de 90% de ce chiffre avec les voitures autonomes, dont seul un nombre infime mettront des personnes en danger.

Faut-il un «logiciel éthique»?

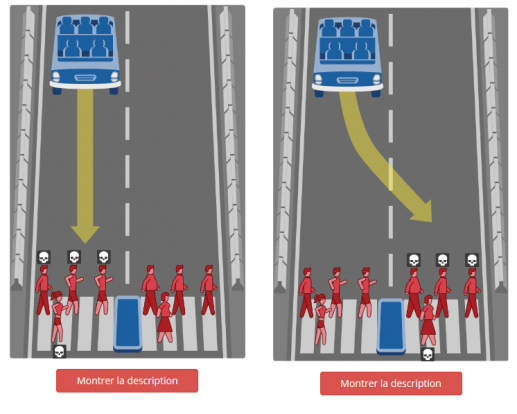

Les voitures autonomes sont munies d’un logiciel complexe. Celui-ci essaiera toujours de préserver les vies humaines. La décision à prendre par la voiture lorsqu’elle ne peut éviter la collision soulève des débats éthiques aux quatre coins du monde. C’est ainsi que le très réputé Massachusetts Institute of Technology (MIT) a conçu divers scénarios invitant chacun à résoudre le dilemme moral. Les freins d’une voiture autonome lâchent: qui faut-il sauver? Les hommes ou les femmes? Les jeunes gens ou les personnes âgées? Les médecins ou les voleurs? Les passagers du véhicule ou les piétons? Prenez les décisions.

Le médecin ou le voleur? La personne âgée ou le jeune? Moi ou toi?

De telles expérimentations constituent une intéressante gymnastique intellectuelle; le dilemme éthique ne pourra être résolu par le logiciel puisque les voitures ne seront jamais en mesure de reconnaître si quelqu’un est voleur ou médecin, s’il est âgé de vingt ou de quatre-vingts ans. Faut-il systématiquement sauver le plus possible de gens? Le hasard doit-il décider? L’automobiliste peut-il choisir entre le mode «Sauve-moi» ou «Sauve les autres», tout comme il existe aujourd’hui un mode Sport et un mode Éco? La solution la plus judicieuse serait celle qui réduit la force d’impact au minimum. Mais cette option a aussi ses avantages et ses inconvénients.

Quelle décision prenez-vous? Continuez-vous tout droit vers les personnes qui ont le droit de traverser? Ou bien roulez-vous en direction des gens pour qui le feu est au rouge?

Dilemme moral et juridique

Pour les fabricants et les législateurs, de telles questions sont difficiles à résoudre. Les questions du MIT montrent que la boussole morale varie d’un individu à l’autre. Ce que décide la majorité n’est pas nécessairement juste, surtout lorsque la décision est prise sur ordinateur et non dans la réalité. Dernier point, mais non des moindres, notre constitution fédérale interdit de mettre les vies humaines en balance les unes avec les autres. «Un seul» mort ne vaut donc pas mieux que cinq morts.

Outre ces choix moraux, se pose la question de savoir qui doit assumer la responsabilité. La nouvelle Audi A8 possède dès à présent toutes les fonctions techniques pour laisser le véhicule conduire en cas de bouchon sur l’autoroute. Il serait bientôt possible de conduire et dépasser jusqu’à une vitesse de 130km/h. Toutefois, la législation n’en est pas encore à ce stade en Suisse pour ce qui concerne la conduite autonome. Le conducteur reste intégralement responsable et doit toujours avoir au moins une main sur le volant. L’Allemagne a d’ores et déjà adopté au cours de l’été 2017 les premières bases légales de la conduite autonome, auxquelles la législation suisse se réfère pour l’instant. Mais comment la responsabilité en cas d’accident est-elle réglementée? Tout simplement: «Celui qui conduit est responsable. Cela signifie que si la voiture circule en mode automatique et que le conducteur n’a pas été invité à en reprendre le contrôle, le constructeur est responsable. Sinon, le conducteur demeure responsable», explique Volker Dohr, avocat d’AMAG Group SA.

Il faut un discours social

Nous allons devoir définir, en tant que société, les «règles de base» de la conduite autonome. Mais pour ce faire, nous devons avant tout nous focaliser sur la mobilité de demain: grâce aux véhicules autonomes, il y aura beaucoup moins d’accidents avec morts ou blessés. La mobilité sera accessible à tous. Quel que soit votre âge, que vous soyez fatigué ou non, vous aurez toujours la possibilité de voyager de A à B. La question de ce qui se passe dans la situation extrême la plus rare, ne doit pas entraver une évolution en soi positive.

En savoir plus sur la conduite autonome

Les actualités et le contexte de l’univers automobile. Abonnez-vous dès maintenant.